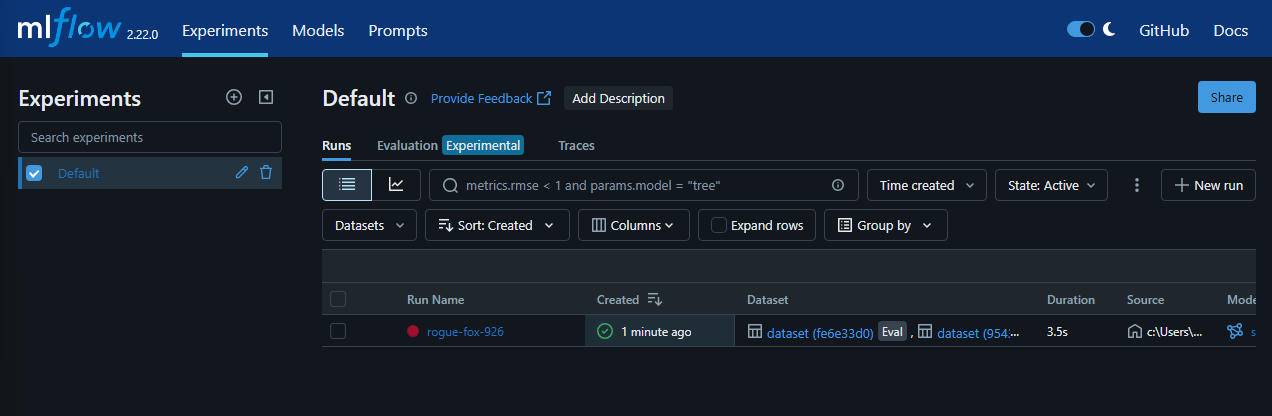

MLflow 설치 및 첫 설정MLflow는 머신러닝 실험을 체계적으로 관리할 수 있는 오픈소스 플랫폼입니다. 실험의 파라미터, 모델, 메트릭을 추적하여 반복 가능하고 재현 가능한 머신러닝 개발 환경을 구축할 수 있습니다.MLflow를 설치하려면 간단히 다음 명령어를 실행합니다.pip install mlflow설치가 완료되면, 다음 명령어로 MLflow UI를 실행할 수 있습니다.mlflow ui웹 브라우저에서 http://127.0.0.1:5000에 접속하면 MLflow UI를 확인할 수 있으며, 이곳에서 실험 결과를 시각적으로 확인하고 비교할 수 있습니다.간단한 모델 학습 및 자동 로깅MLflow의 자동 로깅 기능을 사용하면 모델 학습 과정에서 파라미터, 모델, 메트릭을 자동으로 기록할 수 있습니다. ..